GB10 简介

Dell Pro Max with GB10 是 Dell 针对 AI 开发者推出的一款桌面级工作站,核心搭载 NVIDIA 最新的 Grace/Blackwell 架构超级芯片(GB10),主打能够在本地(按桌面/边缘场景)运行大型语言模型 (LLM) 或其他高端 AI 推理/开发任务。它强调「AI 工具级别」而非普通办公或游戏用途;因此面向的是 AI 工程师、科研人员、对隐私/合规有要求的企业场景。

本次测试使用的配置

机器外观

测试内容

测试内容及目标:

- 测试 Pro Max with GB10 的物理特性、运行温度/散热、图形显示功能、网络及外置存储连接特性。

- 测试不同推理引擎软件在 GB10 的部署,包含 NVIDIA TensorRT-LLM、vLLM 及 SGLang。

- 测试当前业界主流开源 AI 大模型(来自 OpenAI GPT-OSS 系列、阿里 Qwen3 系列、DeepSeek-R1 系列等),基于不同的计算精度(FP4/FP8/BF16),在 GB10 上的部署可行性及压力测试。

- 测试非 NVIDIA 的第三方 AI 平台软件工具,在 GB10 上的部署及效能验证。

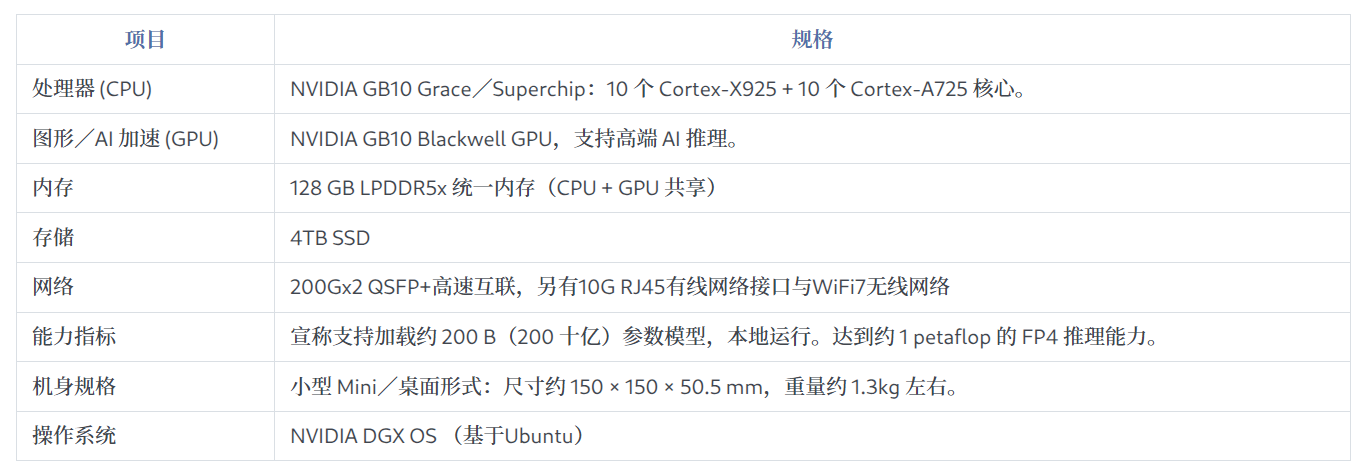

Dell Pro Max with GB10 硬件规格表

Dell Pro Max with GB10 AI 模型适配验证

- 验证 FP8 精度最大参数规模的模型:Llama 3.3-70B(总参数 70B)

- 验证 FP16/BF16 精度最大参数规模的模型:DeepSeek-R1-Distill 32B(总参数 32B)

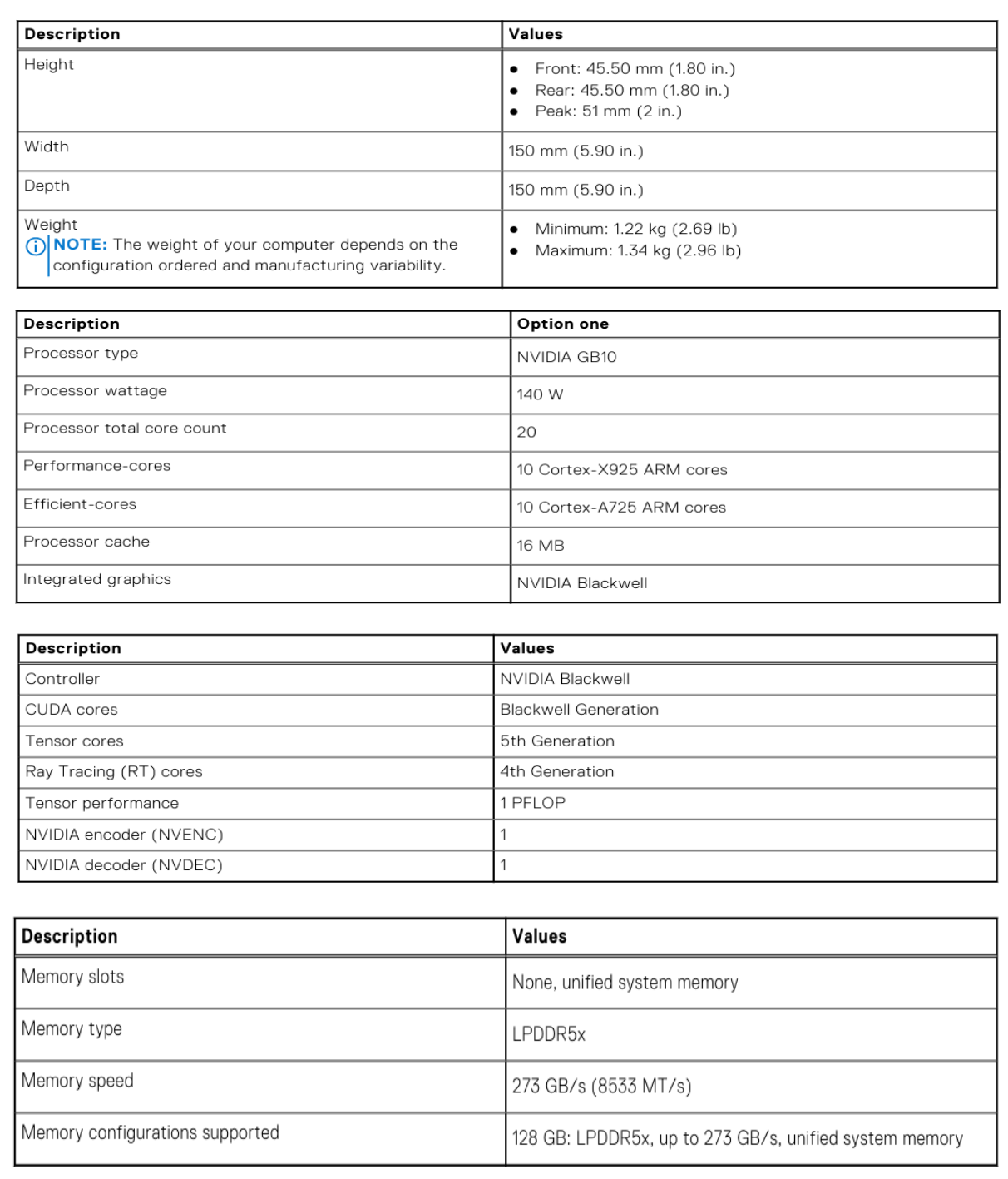

针对不同模型的推理引擎选型

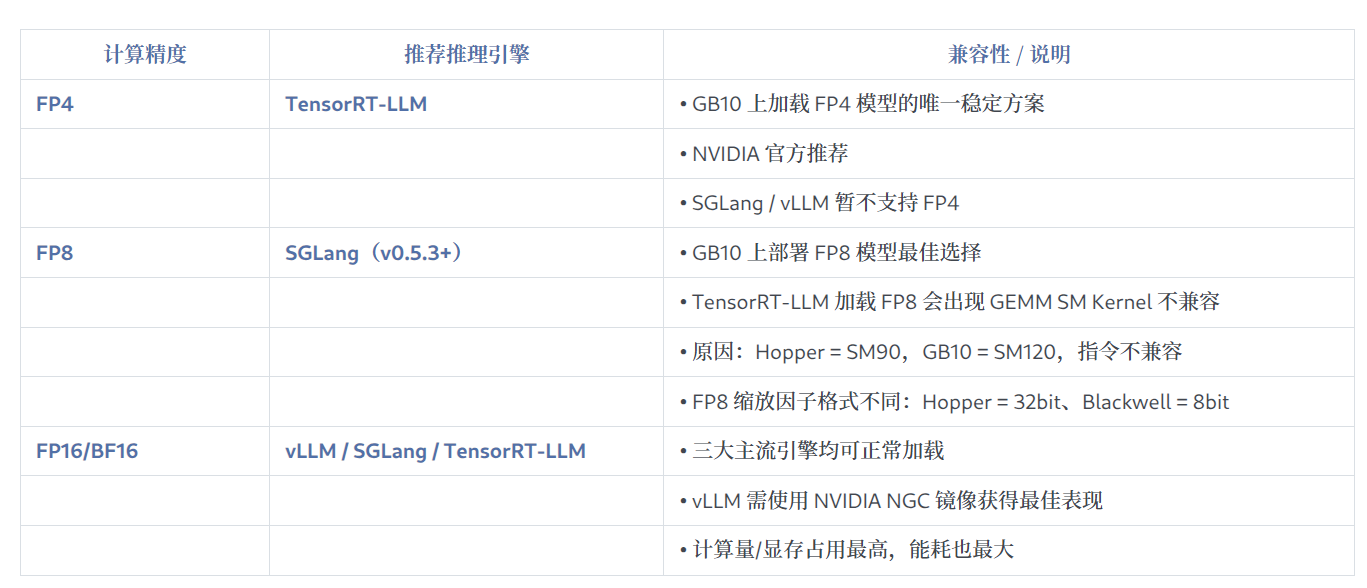

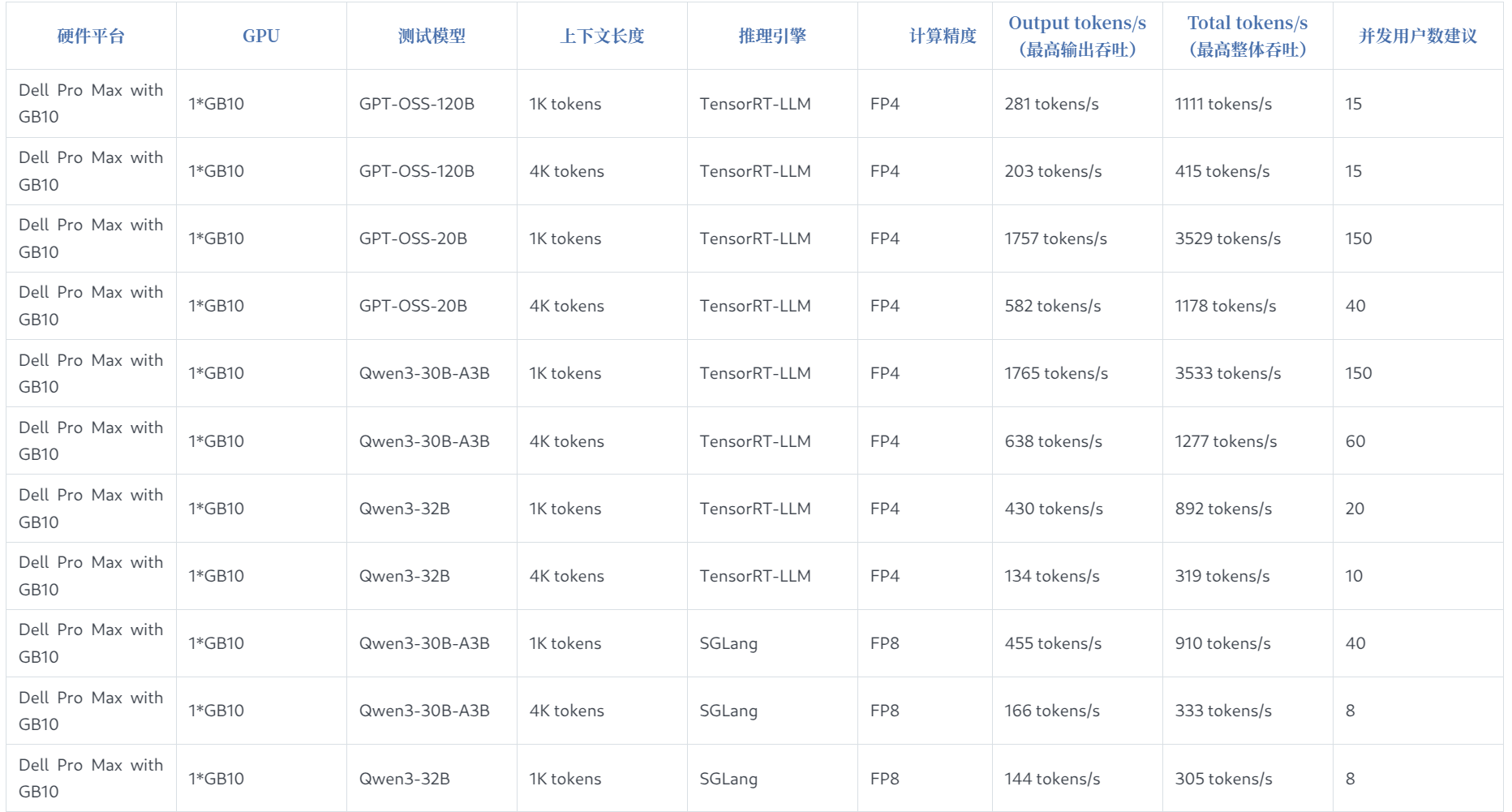

GB10 OpenAI GPT-OSS-120B 模型推理效能测试

测试环境

- 测试硬件设备:1 × Dell Pro Max with GB10

- 推理引擎:TensorRT-LLM 1.1.0rc3

- AI 模型及计算精度:GPT-OSS-120B(FP4 精度)

上下文长度:

- 1K tokens(Input 512 + Output 512)

- 4K tokens(Input 2K + Output 2K)

- 压力测试工具:vllmbench

测试结论摘要

1K 上下文场景下:

- 输出吞吐:可达 281 tokens/s

- 整体吞吐:可达 1111 tokens/s

4K 上下文场景下:

- 输出吞吐:可达 203 tokens/s

- 整体吞吐:可达 415 tokens/s

并发建议:

- 单台 Dell Pro Max with GB10 建议支持并发 15 用户

- 首 Token 延迟 TTFT < 2s

- 后续 Token 延迟 TPOT 约 100ms

- 业务可承受延迟体验下的有效并发

GB10 Qwen3-30B-A3B 模型推理效能测试(FP4)

测试环境

- 测试硬件设备:1 × Dell Pro Max with GB10

- 推理引擎:TensorRT-LLM 1.1.0rc3

- AI 模型及计算精度:Qwen3-30B-A3B(FP4 精度)

上下文长度:

- 1K tokens(Input 512 + Output 512)

- 4K tokens(Input 2K + Output 2K)

- 压力测试工具:vllmbench

测试结论摘要

1K 上下文场景下:

- 输出吞吐:可达 1765 tokens/s

- 整体吞吐:可达 3533 tokens/s

4K 上下文场景下:

- 输出吞吐:可达 638 tokens/s

- 整体吞吐:可达 1277 tokens/s

并发建议:

- 单台 Dell Pro Max with GB10 建议支持并发 150 用户(1K 上下文)

- 单台 Dell Pro Max with GB10 建议支持并发 60 用户(4K 上下文)

- Token 生成延迟表现优于 GPT-OSS-120B,整体 TPS 更高

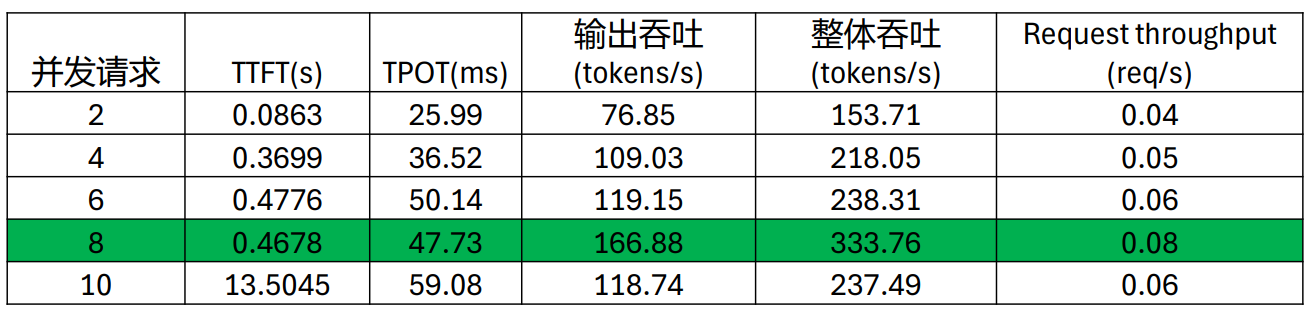

GB10 Qwen3-30B-A3B 模型推理效能测试(FP8)

测试环境

- 测试硬件设备:1 × Dell Pro Max with GB10

- 推理引擎:SGLang v0.5.3rc0

- AI 模型及计算精度:Qwen3-30B-A3B(FP8 精度)

上下文长度:

- 1K tokens(Input 512 + Output 512)

- 4K tokens(Input 2K + Output 2K)

- 压力测试工具:vllmbench

测试结论摘要

1K 上下文场景下:

- 输出吞吐:可达 455 tokens/s

- 整体吞吐:可达 910 tokens/s

4K 上下文场景下:

- 输出吞吐:可达 166 tokens/s

- 整体吞吐:可达 333 tokens/s

并发建议:

- 单台 Dell Pro Max with GB10 建议支持并发 40 用户(1K 上下文)

- 单台 Dell Pro Max with GB10 建议支持并发 8 用户(4K 上下文)

- FP8 精度在 GB10 上吞吐量低于 FP4 版本,但仍具备可使用的性能表现

计算精度对于 Qwen3-30B-A3B 推理效能影响分析(FP4 vs FP8)

- Qwen3-30B-A3B 模型推理测试中,使用 FP4 精度版本,在输出吞吐和并发请求的效能表现,比 FP8 精度版本有很大幅度的提升。

- 1K 和 4K 上下文场景,使用 FP4 精度的每秒 Output tokens 输出吞吐性能,分别是 FP8 版本的 3.87 倍和 3.84 倍;考虑到 TTFT/TPOT 延迟性能的单机 GB10 有效并发数量,FP4 版本在 1K 和 4K 上下文场景下分别是 FP8 版本的 3.75 倍和 7 倍。

- 使用 FP4 精度的 AI 大模型,可以有效提升 GB10 上的推理计算效能。

📊 Qwen3-30B-A3B 不同精度输出吞吐能力对比(FP4 vs FP8)

1K 输出吞吐(tokens/s)

FP4: █████████████████████████████████████████████████████████████████████ 1765

FP8: ██████████████████ 4554K 输出吞吐(tokens/s)

FP4: ██████████████████████████ 638

FP8: ████████ 166📈 Qwen3-30B-A3B 不同精度并发能力对比(FP4 vs FP8)

1K 并发能力

FP4: █████████████████████████████████████████████████████████████████████ 150

FP8: ███████████████ 404K 并发能力

FP4: ██████████████████████████ 60

FP8: ██ 8Dell Pro Max with GB10 AI 大模型推理效能验证总结

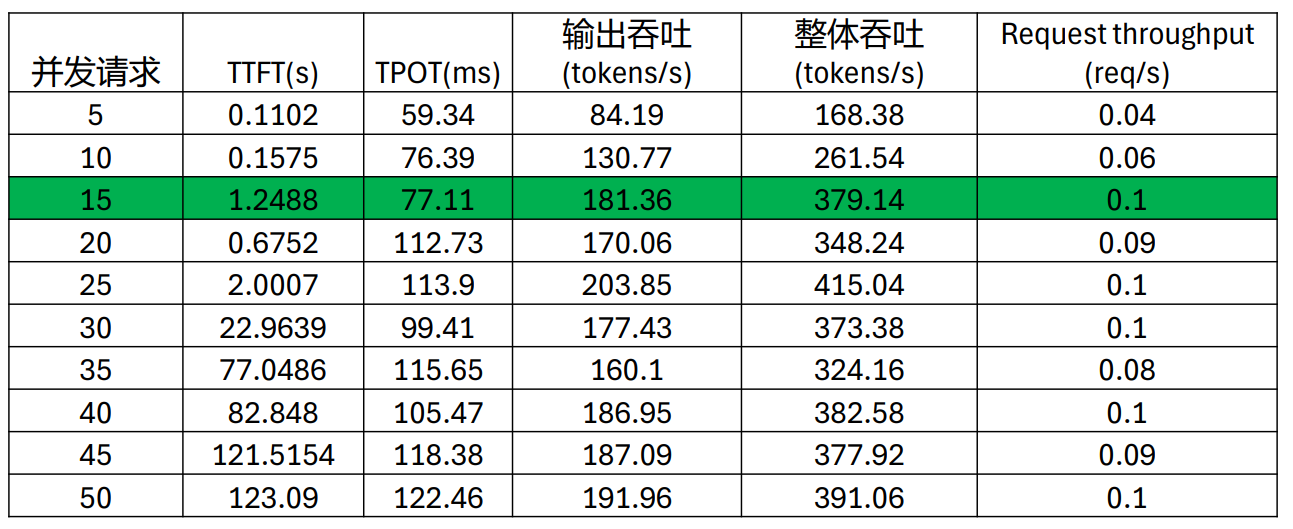

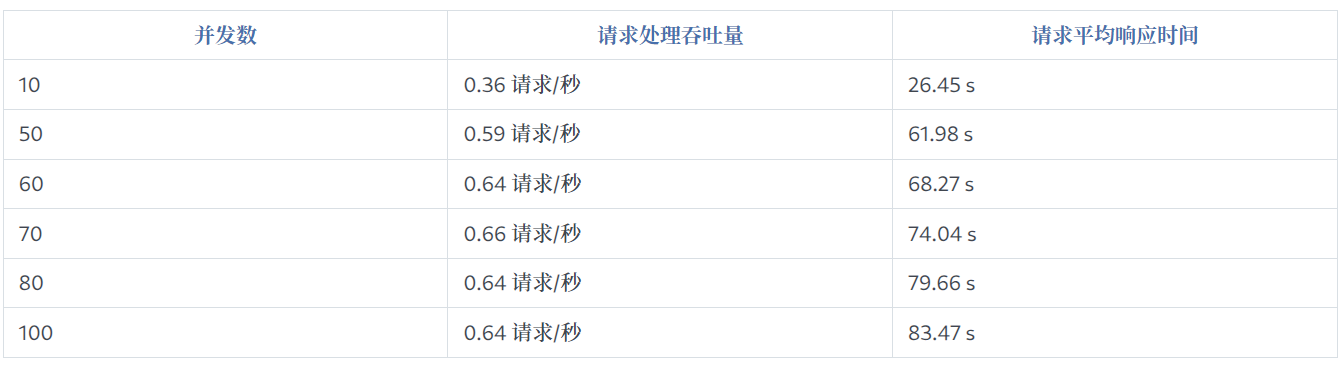

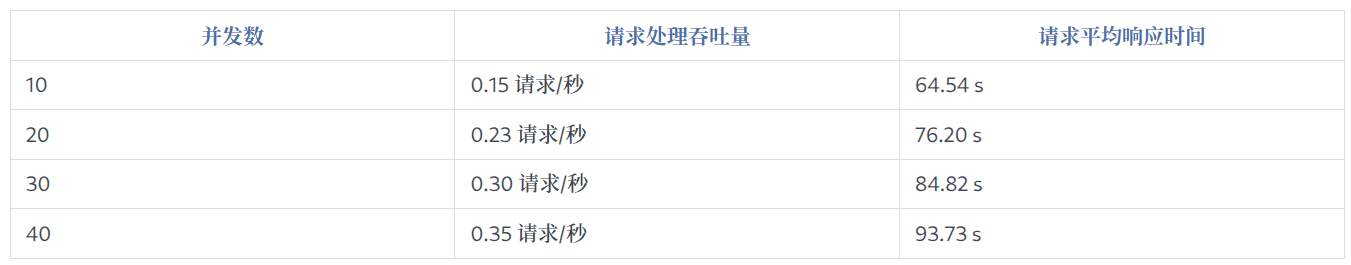

MaxKB GB10 并发压力测试

- MaxKB 是业界流行的一款知识库与智能体平台软件;本测试重点聚焦于「知识库检索+大模型应用」这一核心场景,通过模拟不同量级的用户请求,量化 GB10 系统能保证稳定性能的并发连接数上限。

- 本测试准备了 5000 份文档,约 5400 万个 Token 字符。在流程编排中增加「开始—知识库检索—判断条件—AI 对话」的工作流,来展示查询返回时间。

两种模型的性能特征对比

不同模型在不同并发数下的吞吐量与响应时间

Qwen3-30B-A3B-FP4

Qwen3-32B-FP4

总结

通过本次 Dell Pro Max with GB10 AI 大模型推理效能验证,我们得出以下关键结论:

性能优势显著

FP4 量化技术突破:Qwen3-30B-A3B 模型采用 FP4 量化后,在输出吞吐量和并发能力上相比 FP8 有显著提升:

- 1K 场景下输出吞吐提升 3.87 倍(1765 vs 455 tokens/s)

- 4K 场景下输出吞吐提升 3.84 倍(638 vs 166 tokens/s)

- 4K 场景下并发能力提升 7.5 倍(60 vs 8 用户)

- 企业级应用验证:在 MaxKB 知识库实际应用场景中,GB10 系统展现出优秀的稳定性和性能表现,能够支撑大规模文档检索(5000 份文档,5400 万 Token)与 AI 对话的复杂工作流。

技术价值

- 成本效益优化:FP4 量化技术在保持模型精度的同时,大幅降低了硬件资源需求,为企业部署大模型提供了更经济的解决方案。

- 场景适配灵活:不同模型(Qwen3-30B-A3B vs Qwen3-32B)在不同并发场景下各有优势,企业可根据实际业务需求灵活选择。

- 生产就绪:测试结果表明 GB10 平台已具备支撑企业级 AI 应用的能力,可满足知识库检索、智能客服、内容生成等多种场景需求。

应用建议

Dell Pro Max with GB10 方案适用于需要灵活部署、对机器体积有要求的场景。对于追求高并发、低延迟的企业应用,推荐采用 FP4 量化的 Qwen3-30B-A3B 模型配合 GB10 平台,可获得最佳的性价比和用户体验。